¿Cuántas veces y con qué frecuencia el Crawler de Google visita nuestra Web? En SEO, a esa periodicidad de visitas, es en parte a lo que se le llama Crawl Budget. Este es un factor que, al hablar de temas relacionados con el rastreo y la indexación, debemos tener muy en cuenta.

Por ello, mi objetivo de hoy es el de intentar resolver todas tus dudas respecto a qué es el Crawl Budget, cuáles son los factores que influyen en él y cómo puedo mejorar este presupuesto de rastreo. Pero, primero, quiero contarte la definición de Crawler, término indispensable para entender mejor este tema. ¿Me acompañas?

¿Qué es un crawler?

Un Crawler (robot o araña, como también se lo suele llamar), es un Software que se ocupa de rastrear y explorar todos los sitios Web y sus diferentes URLs de una forma automática y constante.

Todos los motores de búsqueda (o buscadores de Internet) cuentan con estos rastreadores. Ellos van navegando por la red y analizando los diferentes sitios que encuentran a su paso, para crear una base de datos que contenga la mayor cantidad de información recolectada sobre los mismos.

¿Y el Crawl Budget? Todos los que trabajamos en Internet, y sobre todo los que nos relacionamos con el mundo del SEO, seguro que ya hemos oído o leído más de una vez algunas frases en las que se nombraba este término. Pero, ¿realmente sabemos qué significa?

¿Qué es el Crawl Budget?

La definición de Crawl Budget, hace referencia a lo que denominamos “presupuesto de rastreo”. Y, el presupuesto de rastreo, es la frecuencia y el periodo de tiempo que asigna Google a una Web para ocuparse del rastreo de sus URLs y del contenido existente en las mismas.

A su vez, esto en SEO significa que, en base a ese presupuesto, Google Bot pasará más o menos tiempo rastreando e indexando las diferentes URLs de nuestra Web. Factores como la autoridad, la velocidad de carga, la frecuencia de publicaciones y la antigüedad del sitio, entre otros, tienen una influencia importante para dicho Budget.

Pero, quizás ahora, te estés preguntando: ¿es esto realmente importante para mí?

Aunque, en un principio pensemos que no es tan relevante que ese Crawl Budget sea mayor o menor en nuestro sitio, deberíamos saber que esto es algo de vital importancia cuando hablamos de cualquier proyecto que más o menos comienza a tener una mayor envergadura.

Y ahora veremos el porqué.

¿Por qué debes tener un buen presupuesto de rastreo?

Partamos del ejemplo de una Web que tiene X presupuesto de tiempo asignado por Google para su rastreo. El Bot pasará por la misma, empezará a rastrearla, a navegar por sus URLs, etc. y, una vez acabado el tiempo estimado por este Crawl Budget, dicho Bot saldrá de esa Web.

Pero, he aquí el quid de la cuestión: si el lapso de tiempo que tienes asignado es pequeño, es muy posible que Google Bot salga de ese sitio antes de haberse ocupado de todo el contenido (antiguo o nuevo) que se haya introducido en esa Web.

¿Qué problemas podemos tener en caso de que sea bajo?

Tu Crawl Budget definirá que contenido de tu sitio Web será rastreado y cuál no

¿Y qué significa esto? Que muchos de los contenidos que tenga tu sitio no serán indexados y, por lo tanto, tu Web se enfrentará a varios problemas, como por ejemplo:

- 1º Que ese contenido no llegue a posicionarse, ya que ni siquiera Google sabrá que existe.

- 2º Que se siga generando contenido que no esté indexado, pero que si aumente el tamaño del proyecto, haciendo esto, que sea más difícil aún para Google encontrarlo. Lo que significa que, el tener un presupuesto de rastreo bajo, se irá sumando una mayor distancia hacia algunas zonas de la Web que pasarán a ser invisibles para el buscador.

- 3º Si Google tarda mucho tiempo en rastrear y reconocer tu contenido, cuando algún competidor lo copie y lo indexe antes que tú, el mismo Google determine que el suyo es el original. Y esto, hará que te asigne a ti el duplicado o copia y la potencial penalización que eso puede acarrear.

- 4º Otro gran problema que podemos tener, es que Google tarde mucho tiempo en coger cualquier tipo de cambio que hagamos a nivel de SEO On Page, algo que a su vez retrasa el tiempo en que se ven plasmados los resultados de cada uno de esos cambios que hagamos en nuestra Web.

Con estos ejemplos se pueden ver claramente algunas de las desventajas a las que nos enfrentamos cuando contamos con un presupuesto o Crawl Budget bajo.

¿Cuál es la importancia de aprovechar tu Crawl Budget?

No solo es importante conseguir tener un buen Crawl Budget, sino también saber aprovecharlo lo mejor posible.

Y es que, por mucho tiempo de rastreo que nos asigne Google, si no lo aprovechamos, no nos servirá de casi nada.

¿Qué quiero decir con esto?

Que, primero que nada, deberíamos tener muy bien optimizada nuestra Web para aprovechar el 100 % de nuestro presupuesto, y para que el Bot no se pierda en el camino del rastreo de nuestros contenidos.

Y sobre el cómo aprovechar y mejorar este Crawl Budget, es algo de lo que hablaremos un poco más adelante, junto a mi amigo David Ayala.

Él nos va a contar todos los detalles acerca de cómo podemos mejorar el Crawl Budget en nuestra Web o eCommerce.

¿Puedo mejorar el Crawl Budget para potenciar mi posicionamiento?

Una mejora sustancial en el Crawl Budget va a repercutir de forma casi directa en la velocidad de indexación de tus páginas y contenidos.

Ahora bien, para ello, necesitas conocer mejor el comportamiento de GoogleBot.

Por otro lado, a veces, no por el solo hecho de tener una mayor frecuencia de rastreo por parte del buscador vas a indexar más rápido y posicionar tu sitio Web mejor. Pero, antes de seguir hablando de esto, necesitamos entender mejor cómo se está comportando el Bot de Google en nuestro sitio.

¿Cómo se comporta Google en nuestra web?

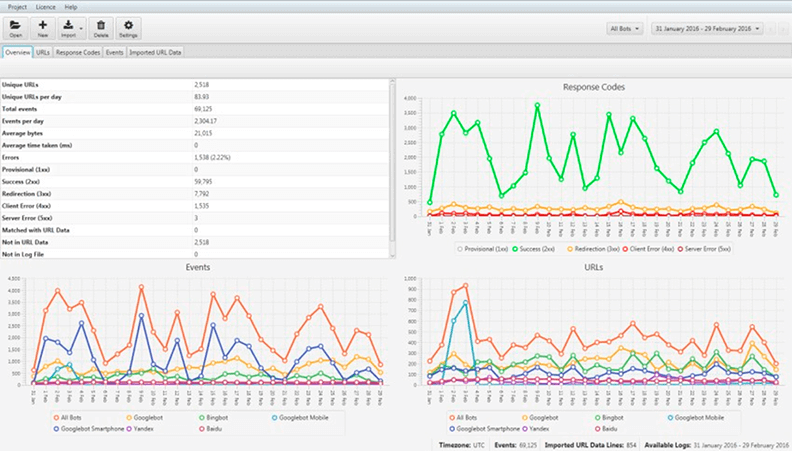

Algo muy importante para poder comprender a qué zonas le está dando más importancia y cómo se comporta Google en nuestra web, es echar un ojo a los logs.

Los logs están almacenados en nuestro propio servidor, y podemos acceder directamente a ellos para ver cómo son los accesos que está efectuando Google Bot y qué zonas visita en cada momento.

Eso sí: hay que reconocer que hacer esta comprobación puede resultar un poco tediosa, pero por suerte existen programas como Screaming Frog Log File Analyser que nos pueden facilitar mucho el proceso.

Gracias a Screaming Frog podemos, por ejemplo, comprobar exactamente:

- Por dónde navega Google

- La frecuencia con que lo hace

- Las zonas que más frecuenta

- Las que producen una redirección

- Además de un gran número de datos que nos ayudarán a comprender mejor cómo se comporta Google en nuestra web

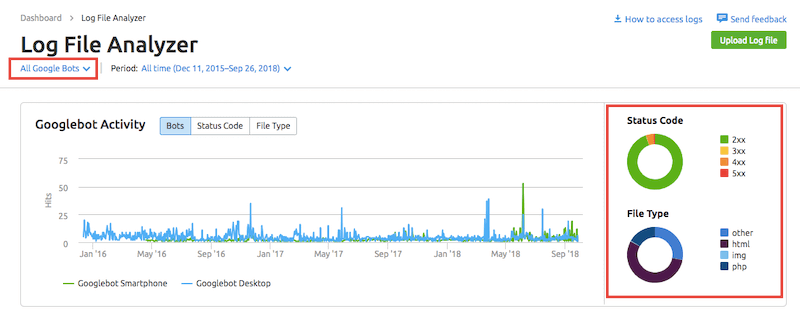

SEMrush es otra herramienta que ha lanzado una opción para poder analizar Logs.

SEMrush Log File Analyser

Llegados a este punto, ya tenemos toda la información necesaria como para poder empezar a trabajar en nuestra web y poder así optimizar y aumentar nuestro Crawl Budget.

¿Cómo optimizar nuestro Crawl Budget?

En primer lugar, lo que nos interesa es optimizar lo que ya tenemos, es decir, sacar el máximo provecho al presupuesto de rastreo que tenemos actualmente asignado.

Para conseguirlo, presta atención a las siguientes recomendaciones.

«Optimiza tu Crawl Budget con estas recomendaciones»

Seguir la filosofía del “Menos es más”

Cuando digo «menos es más» me refiero a que no por tener 100.000 páginas indexadas de tu web en Google vas a conseguir más visitas que teniendo tan solo 1.000.

Esto puede transformarse en un problema, ya que muchas personas tienden a generar mucho contenido que realmente no sirve de nada o que no va a posicionar en la vida porque piensan que el contenido en grandes cantidades posiciona, cuando realmente puede hacer el efecto contrario.

Si haces que Google Bot pierda el tiempo en muchas URLs que no te interesan, no va a rastrear las que de verdad quieres posicionar, y por lo tanto estarás desaprovechando tu Crawl Budget en páginas sin sentido.

Por ello, lo mejor es que si tienes una web de tamaño mediano/grande, te preguntes primero qué contenido merece la pena conservar y cuál deberías eliminar.

Del mismo modo, otros tipos de contenidos como los generados por paginaciones, parámetros, etc., son contenidos que solo le harán perder tiempo a Google Bot.

Elimina los contenidos que sean innecesarios y con los que no puedas eliminar, simplemente utiliza las etiquetas robots noindex nofollow y bloquéalas con el archivo robots.txt.

Lo mismo ocurre con los contenidos susceptibles a canibalización, es decir, aquellos que compiten por las mismas keywords dentro de tu propia Web.

En raras ocasiones se puede posicionar un conjunto de los propios contenidos en los primeros puestos para términos similares, convirtiéndose en un gasto innecesario de rastreo.

En este caso, en vez de eliminar los contenidos que compitan entre sí, elige solo la versión que esté mejor posicionada y a las otras, hazles una redirección 301.

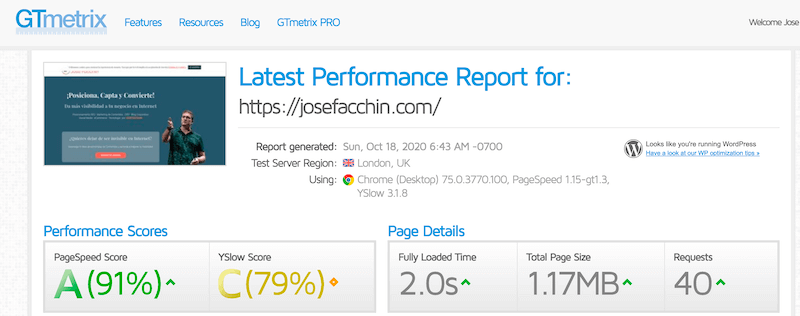

Optimiza la velocidad de carga

Si tu web tarda mucho en cargar, Google Bot va a tener menos tiempo para poder rastrear páginas internas de tu web y, por lo tanto, va a perder más tiempo esperando que rastreando.

Por eso, es muy importante que consigas que tu Web sea lo más rápida posible en todos los aspectos.

Para ello, optimiza el código fuente de tu sitio para no insertar códigos innecesarios, javascripts que no se usen, CSS antiguos que no se estén usando, imágenes demasiado pesadas, etc.

» También te puede interesar: ¿Qué es el WPO?

Del mismo modo, un buen servidor te puede ayudar a mejorar la velocidad de carga de manera considerable, además de optimizarlo usando sistemas de caché tanto a nivel de servidor como a nivel de CMS.

Vigila enlaces y redirecciones problemáticos

Lo mismo ocurre con las redirecciones innecesarias, ya que cada una por la que pasa Google Bot, es un tiempo que se pierde de nuestro presupuesto de rastreo.

Para evitarlo, debemos intentar utilizar las mínimas redirecciones posibles, y sobre todo no enlazar a URLs redireccionadas.

Enlazar a páginas que den error 404 es sin duda otro inconveniente, ya que haremos que Google pierda tiempo en visitar URLs que ya no existen o que dan error, perdiendo con ello aún más presupuesto de rastreo.

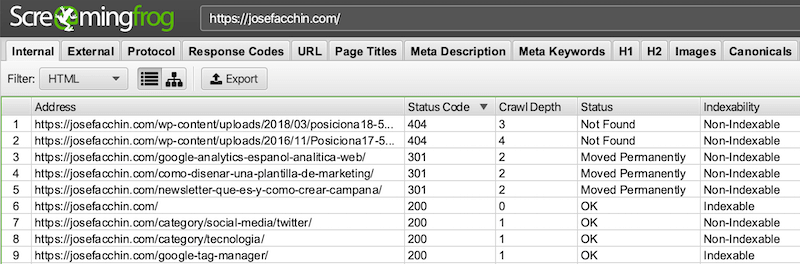

Con Screaming Frog (y también con SEMrush, Ahrefs, SERanking o DinoRANK) podemos comprobar las URLs que tengamos redireccionadas y las páginas que nos den error 404, para luego corregirlo.

Otro gran problema es enlazar a páginas que realmente no nos interesa posicionar, como por ejemplo:

- Los avisos legales

- Las políticas de cookies

- Las páginas de contacto

A este tipo de enlaces los colocamos, sin casi darnos cuenta, en prácticamente todas nuestras URLs, y eso hace que Google Bot las visite en reiteradas ocasiones y pierda mucho tiempo en el proceso.

Una solución para este tipo de páginas es utilizar el atributo rel nofollow, aunque esto no es recomendable porque vamos a perder parte de link juice de esa página al usarlo.

Lo ideal es hacerlo accesible, pero sin un link. Pero ¿Cómo? Muy fácil: mediante javascript o jquery.

Diseña una estrategia de enlazado interno

Como bien sabemos, cuantas más URLs enlacemos desde nuestros menús y desde las zonas comunes de nuestra web, más tiempo le haremos perder a Google Bot rastreándolas.

Por ello, no es aconsejable abusar de las zonas de menú que se comparten en las URLs de nuestra web. A estos espacios los reservaremos para dedicárselos a las zonas que queramos reforzar de cara al SEO.

Ya vimos anteriormente cómo saber cuáles son las URLs que Google Bot visita con más frecuencia en nuestra web, esas zonas más calientes.

El próximo paso es aprovechar esas zonas para enlazarlas a otras que queramos darle más énfasis y para que el Bot no pierda tanto tiempo en otras sin tanta importancia.

¿Cómo aumentar nuestro presupuesto de rastreo?

Ahora que ya hemos conseguido aprovechar el 100 % nuestro presupuesto existente de rastreo, veremos qué podemos hacer para aumentarlo.

Y esto, contrariamente a lo que estarás pensando, es algo bastante complicado de hacer.

Google puede tener tu web encasillada en cuanto al tiempo de rastreo que mereces. Esto es, nada más y nada menos, que una asignación pura y dura (y a veces arbitraria).

Sin embargo, aumentar ese presupuesto no es tarea imposible y con trabajo se puede conseguir.

Ahora bien: ¿cómo podemos hacerlo? Básicamente, hay dos caminos a seguir.

Aumentar la autoridad de la URL

Si queremos aumentar la frecuencia de rastreo de nuestra web tenemos que aumentar la autoridad de la misma para que así Google determine que esa web tiene una mayor importancia, y para “obligarlo” a que pase con mayor frecuencia.

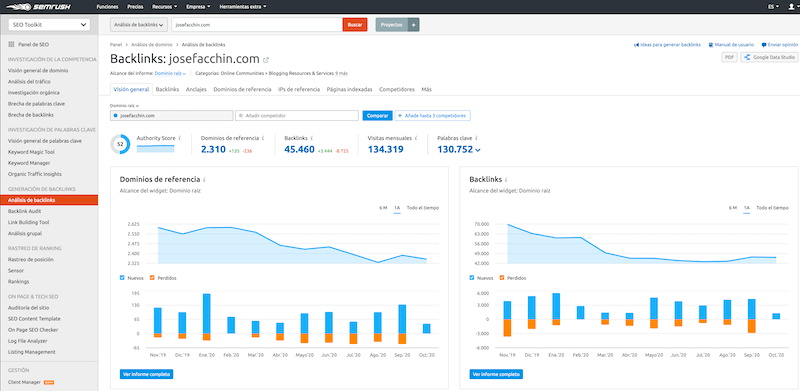

Ejemplo con Semrush:

Una forma de conseguir esto es a base de linkbuilding de calidad.

Prueba Gratis de Semrush

Si conseguimos enlaces de calidad hacia nuestras URLs, estaremos pasando un gran Link Juice hacia nuestro sitio Web, lo que aumentará la autoridad de nuestra web, hará que se posicione mejor y, como si esto no fuese poco, hará que Google le dé más relevancia.

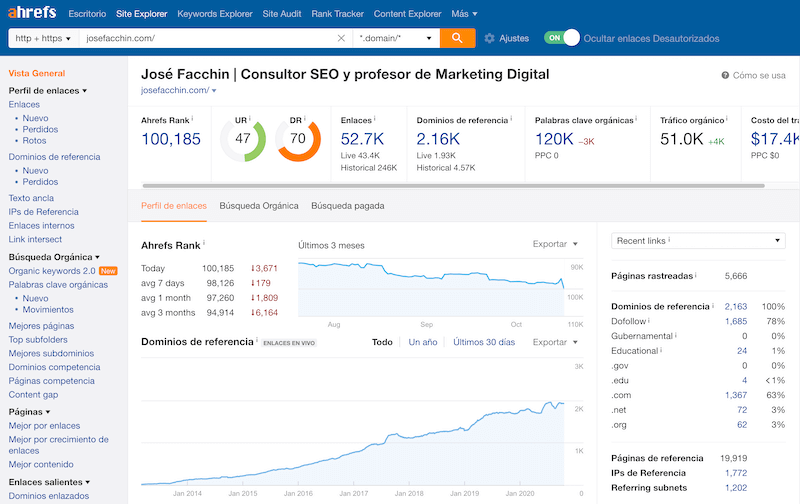

Ejemplo con Ahrefs:

Actualizar los contenidos

Si nuestra web es estática y siempre tiene los mismos contenidos, es normal que Google Bot determine un presupuesto de rastreo bajo, ya que no va a encontrar nada nuevo cuando vuelva a acceder, y por lo tanto no desaprovechará sus valiosos recursos.

Es por ello que es importante actualizar los contenidos de nuestra web, ya sea de forma estática y dinámica.

Si tenemos una web tipo blog, podremos actualizarla regularmente sin problemas con contenido nuevo y rastreable por Google.

Si, en cambio, nuestra web es más bien estática, con un mismo número de URLs, la cosa puede complicarse, aunque también aquí contamos con una solución: la de actualizar los textos del contenido estático con regularidad.

Esto último es algo que también funciona muy bien cuando no se generan URLs nuevas.

Conclusión

Al realizar una auditoría SEO, debemos tener en cuenta que este no es un factor que te haga mejorar el posicionamiento de una Web directamente. Pero, sí hay algo que debemos reconocer: cuando el Crawl Budget mejora, nuestro posicionamiento también suele hacerlo.

¿A qué se debe esto? A que cuando este aumenta, el rastreo e indexación de las páginas también lo hace con él, posicionando más fácilmente las nuevas URLs y cogiendo más rápido los cambios a nivel On Page que vayamos realizando.

Para ir finalizando, y como vimos a lo largo de esta guía, son muchos los beneficios directos e indirectos que pueden ayudarte a mejorar el SEO de tu Web.

Por eso me gustaría despedirme con un par de preguntas:

¿Tienes claro cuál es tu Crawl Budget?

Y en caso afirmativo: ¿estás seguro de estar sacándole el máximo provecho?

¡Hasta la próxima, amigos!

Hola chicos,

Apenas estoy empezando y me mola un poco el mundillo del SEO, veo que tiene mucho de donde tirar. A ver si soporto el mercado, jeje.

En mi caso sólo lo quiero para intentar posicionar mi sitio poco a poco e ir colocando contenido útil para los usuarios que utilicen el buscador de Google y que me sirva para posicionarme.

Sé que son muy pocas las chicas que se dedican a ello. En mi caso simplemente quiero que me aclaren con qué herramientas podría conocer mi presupuesto de rastreo o si Google lo asigna aleatoriamente según la autoridad que gane mi página con el tiempo, entre otros factores.

¡Tremendo post!

Hola Jenifer, te deseamos mucha suerte y estamos muy agradecidos por tu feedback positivo en el post 🙂 Saludos

Gracias Jose. Sabes ¿Con cuáles herramientas podría conocer mi presupuesto de rastreo o si Google lo asigna aleatoriamente según la autoridad que gane mi página con el tiempo, entre otros factores SEO?

Hola Jenifer,

Puedes usar SEMrush o Screaming Frog, además de tu propio Google Search Console, para conocer los datos que necesitas.

Saludos

Hola Jose

Por tus post me parece que se resume en producir nuevo contenido de calidad, y de mejorar la calidad del ya existente

Gracias por compartir, me gustan los posts, asì, detallados pero al grano

Saludos desde Caracas

Hola Luis, te agradecemos tus palabras, esperamos que tengas un buen año y muchos éxitos. Saludos

A mí personalmente me gusta mejorar la velocidad del sitio web para optimizarlo. Sin duda se puede perder muchos recursos si tu web es lenta y no carga bien por tener demasiadas cosas.

Hola Borja, sin duda, la velocidad de carga del sitio web es un factor muy importante. Gracias por tus aportaciones.

Hola, no me ha quedado claro en el artículo la explicación sobre las páginas de Aviso legal, Cookies, etc. Propones y cito literalmente «Lo ideal es hacerlo accesible, pero sin un link. Pero ¿Cómo? Muy fácil: mediante javascript o jquery». ¿Podrías explicar en detalle este punto?

Yo lo que haría es bloquear estas páginas por robots.txt. ¿Qué opinas?

Si pones nofollow o usas robots.txt podrías intentar salvar el crawl budget, pero aun así queda el reparto del link juice en el aire, por que se pierde el link juice que debería de ir a parar a ese link. Por lo tanto lo mejor en estos casos es ofuscar esos links con javascript o jquery y así para el usuario es accesible pero para Google no existe el link.

Hola a todos! Maravilloso post!

Muchas gracias por compartir esta información tan detallada y de valor. Tener en un mismo post una hoja de ruta de buenas maneras para mejorar el posicionamiento de nuestras web se agradece mucho. Estoy de acuerdo que una buena estrategia y mucha calidad garantiza el éxito. También que esto se logra con trabajo. Un abrazo a todos!

Buenas,

En teoría si tenemos dado de alta nuestro sitemap en Google Search Console, Google va a tener acceso continuo a todos y cada uno de los contenidos de nuestra web. Imagino que esto debe ser importante para mejorar el Crawl Budget, ya que evitamos que el bot ande de un sitio a otro, de enlace a enlace, sin orden y con pérdidas de tiempo en la búsqueda de contenidos.

¿Qué opinas de esto?

Un saludo

Realmente si tienes un buen enlazado interno y una buena estructura en tu web (esencial), conseguirás que Google navegue por todo igualmente. Sobre el sitemap, tener uno subido, no implica que Google vaya a indexar todo, ya que depende de muchos factores más. Sobre perdidas de tiempo, realmente el sitemap no te ahorra tiempo, lo único que te puede ayudar es a que encuentre esas urls y las indexe «al principio», pero luego GoogleBot navegará por tu web, no por el sitemap, no se si me explico jeje.

Gracias

Por fin parece que se impone en sentido común, la calidad sobre la cantidad o popularidad.

Poder crear material de calidad y que google te lo valore por encima de otros parámetros me parece genial, porque nos obliga a esforzarnos para crear contenidos de calidad para los visitantes

¡hola…!

Yo de esto no entiendo: lo mio es la programación y, hasta ahora, me limitaba a hacer las partes que trataban datos y hacían cosas. pero no me ocupaba de contenidos ni de posicionamiento. Pero ahora estoy haciendo un sitio propio y tengo que ocuparme de todo lo que no es programación pura.

Una duda que me surge de cara a todo esto es la siguiente:

Yo utilizo muchísimo preprocesamiento (PHP, sobre todo) y una técnica que utilizo mucho es que las páginas que deben mostrar listas de enlaces, (por ejemplo, una página que lista los artículos de un blog) NO CONTIENEN NIGUN ENLACE HASTA EL MOMENTO DE DESPACHARLA AL CLIENTE. Es decir, en su lugar hay una función que lee el contenido de un directorio y genera un array con los nombre de los archivos html que cumplen con un criterio determinado. A continuación la función compone las etiquetas «a» con los href y demás propiedades que correspondan y se hace el despacho al cliente. Esto significa que, mientras no haya un cliente haciendo una petición la pagina no contiene una lista de enlaces, si no que solo contiene una llamada a una función o a una clase que se ejecuta en el momento previo al despacho. ¿por qué lo hago así?. sencillo: para añadir nuevas paginas tan solo tengo que colocarlas en el directorio adecuado y la función PHP escribirá el html pertinente sin necesidad de tener que alterar nada en la pagina que hace el listado ni tener que añadir ningún registro a ninguna base de datos. Y, otro efecto derivado, es que no es posible que al cliente se le muestren enlaces rotos porque la función solo muestra enlaces a paginas que existen en cada momento…

No sé si me explicado bien y me has entendido. La pregunta es, ¿Sabe google preprocesar las funciones PHP para para darse cuenta de que en una pagina se escriben enlaces en el momento de ser servida, o, simplemente, no sabe hacerlo y, por tanto, no «vé» que esa página contiene enlaces?

He logrado expresarme? No, ¿verdad?

Hola, PHP se interpreta a nivel de servidor, es decir, ni Google ni el usuario pueden ver esas funciones php, si no que tan solo podrán ven el codigo fuente final. Para analizar exactamente lo que ve Google a nivel código, puedes ver el codigo fuente directamente desde cualquier navegador (es una opción que incluyen todos los navegadores).

Un saludo!!

Sí. Efectivamente PHP se ejecuta en el servidor y al cliente solo le llega el codigo fuente que se ha generado DESPUÉS de la ejecución de las funciones oportunas… Y esa es exactamente mi pregunta: ¿Google ve EXACTAMENTE lo mismo que ve el cliente en su navegador?… O, preguntado de otro modo: ¿El servidor trata de la misma manera una petición tanto si proviene de un visitante cualquiera (que se ejecuta el PHP necesario antes de servir la respuesta en forma de código html y css) como si proviene de un bot de google?.

Gracias por responderme.

Buenas, exacto, da igual que sea un bot o sea una persona, el servidor interpreta primero el código PHP antes de mostrar nada, por lo tanto no te preocupes por que no verá nada Google en cuanto al PHP, verá el código final directamente. Otra cosa es ya con javascript y similar, que son códigos de ejecución en navegador, ahí si que cambia todo bastante.

Muchas gracias!!!

Esto me aclara definitivamente mis dudas.

Sin duda alguna, el SEO, así como el blogging y el Social Media, requiere de estrategia y trabajo táctico. Esto del Crawl Budget lo demuestra, ya que para que Google considere interesante aportarle más tiempo de rastreo a nuestras webs, es necesario que le lancemos el mensaje correcto: es decir, Google debe considerar que nuestro contenido es de calidad, y esto se consigue solamente con el tiempo, y como ya hemos dicho, trabajando estratégicamente.

Muchas gracias Juan, pues así es como lo vemos también nosotros, perfecta la explicación que has dado.

Buenas Juan, ¡Gracias por tu comentario! Totalmente de acuerdo, hay que darle a Google calidad más que cantidad.