¿Te imaginas una herramienta que pudiera analizar miles de URLs de manera automática? «Screaming Frog SEO Spider» puede hacer eso y mucho más, como te mostraremos en esta súper guía paso a paso.

Si ya sabes qué es el SEO y quieres trabajar para mejorar el posicionamiento de diferentes proyectos de mediana o gran envergadura, es importantísimo conocer en detalle todos los entresijos del On-page de esos sitios web. Es aquí, que disponer de un software de escritorio tan potente como éste, es una gran ayuda para nuestro día a día.

Pero, antes de ver lo que Screaming Frog puede hacer por ti y, sobre todo, para facilitarte tus futuras acciones de posicionamiento, ha llegado el momento de mostrarte la definición más exacta de esta herramienta:

¿Qué es Screaming Frog y para qué sirve?

La herramienta Screaming Frog es un software de escritorio disponible para Mac, Windows y Linux. Se trata de una araña (o SEO spider) que se encargará de rastrear todas las URLs de una web, enlace por enlace y contenido por contenido, para crear un reporte o mapa completo con el estado de salud On-page de ese sitio.

Más adelante verás todos los usos que se le puede dar a esta plataforma, pero ahora te adelanto algunos:

- Saber los H1 que te faltan en diferentes páginas.

- Ver si te faltan meta títulos y meta descripciones.

- Detectar redirecciones 3XX, errores 4XX, etc.

- Analiza el código CSS, HTML y JavaScript.

- Crawlear un sitio al máximo.

- Conocer la profundidad de tu web.

- Y un montón de cosas más…

En definitiva, la “rana gritona” te creará un informe completo con el que podrás analizar tu sitio web desde una perspectiva SEO para después tomar decisiones.

¿Te imaginas analizar más de 5.000 URLs una por una y de forma manual?

100% Inviable… ¿verdad?

Sin embargo, con la ayuda de esta herramienta SEO podremos conseguir esto y mucho más. Ella es una de mis plataformas de analítica On-Page y Off-Page preferidas, junto a SE Ranking, Ahrefs y Semrush.

¿Puede «Screaming Frog» analizar todas y cada una de las URLs de una web por muy grande que sea ésta?

Precisamente ésta es una de las grandes ventajas de este software, ya que, aunque el proyecto que queramos analizar tenga cientos o incluso miles de URLs, podrás hacerlo sin problemas.

Además, todos estos datos podrás extraerlos a una hoja de cálculo Excel, para poder trabajar sobre ellos en tu dispositivo, aunque no dispongas de conexión a Internet en un momento dado.

Todo ello nos lo contará Fran Murillo (profesor del curso de SEO en Webescuela), que en este post de invitado nos hará un completo repaso a modo de manual o guía paso a paso, para este potentísimo software de análisis Web. ¡Vamos ella!

Screaming Frog SEO Spider en español: La guía más completa del crawler y el análisis On-Page

Si hablamos de SEO no podemos dejar de lado las herramientas que nos facilitan nuestro día a día, y por supuesto si hacemos una lista de las más útiles, ésta debe aparecer sin lugar a dudas.

Es por eso que en el post de hoy voy a tratar de hacer un post completo y profundo sobre ella e intentar hacerla interesante, para todos los que tengan cierto interés en tener un SEO On-Page cuidado.

¡Quédate hasta el final y domina a la rana!

► Consideraciones iniciales antes de usar la herramienta

Si la introducción al uso de la herramienta te ha convencido, es momento de hacerte con ella.

Para ello, debes elegir entre dos opciones:

- Por un lado tienes la versión gratuita con restricciones, con la que solo podrás analizar 500 URLs

- Y por otro la de pago, que por 185€ te dará acceso completo por un año.

Si tienes dudas de las diferencias entre ambas versiones, te recomiendo que vayas a este enlace, así podrás descargarte la versión que más te convenga.

¿Cómo usar Screaming Frog SEO Spider? Primeros pasos

Luego de ver el anterior vídeo tutorial, supongo que ya te has hecho con tu flamante licencia y seguro que ya estás deseando darle caña, no obstante, antes de comenzar con ella, vamos a hacer una serie de cambios.

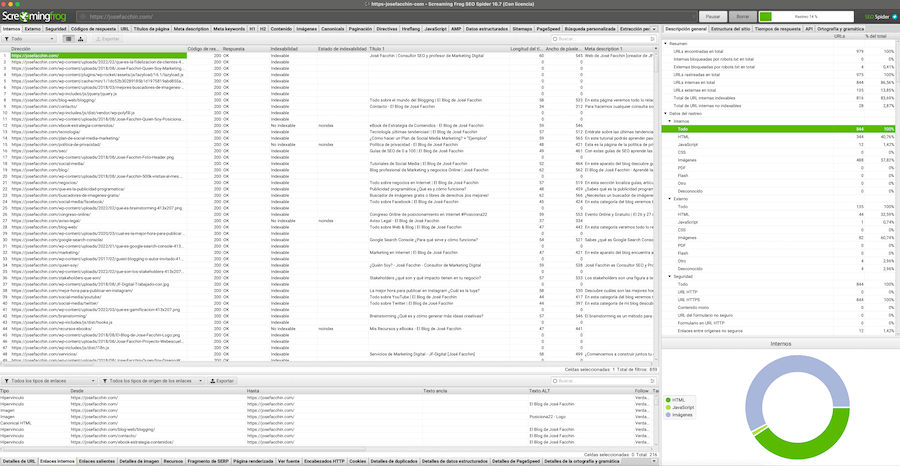

Por un lado, veamos de manera más detallada cómo es la interfaz de este programa, nada más abrirlo (actualmente utilizo la última versión 16.7):

Tal y como ves se trata de una interfaz limpia y muy intuitiva, en ella puedes ver un menú superior y una serie de pestañas más abajo. También tiene un sidebar a la derecha y, por último, un campo de entrada de nuestra URL.

Fácil, ¿verdad?

En fin, ya conoces la interfaz de la herramienta, ahora entremos en su configuración.

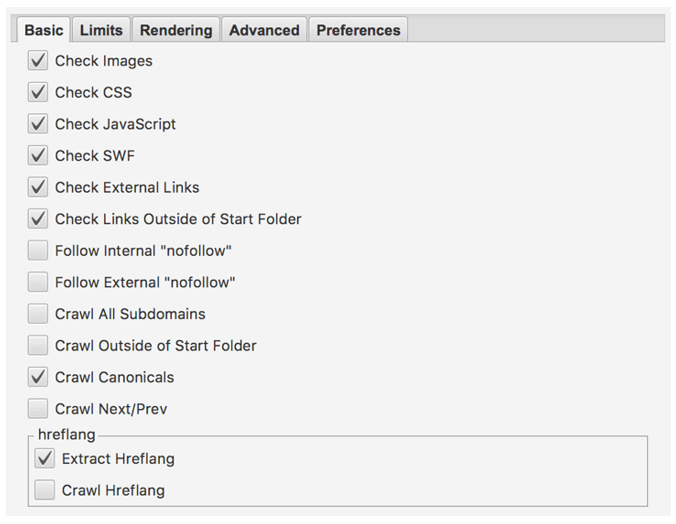

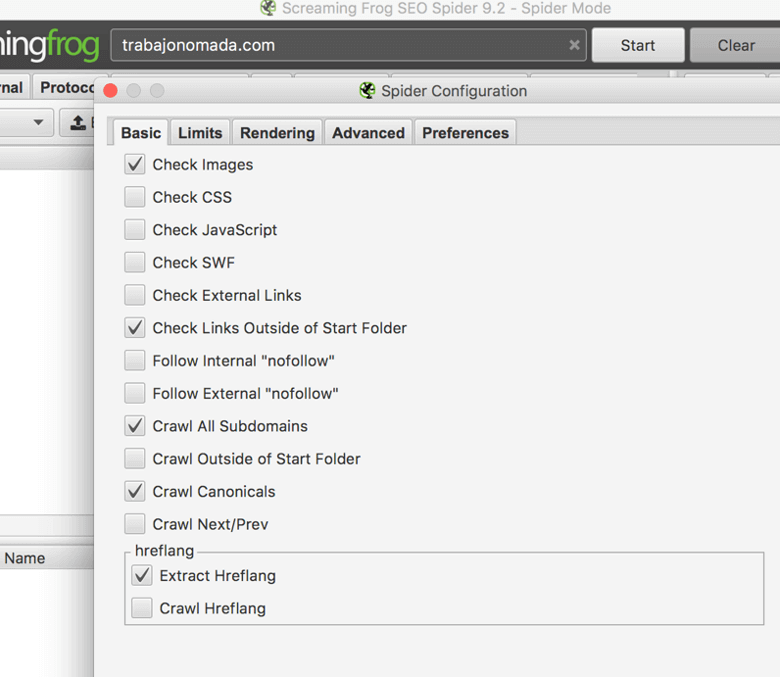

Antes de realizar un crawl, vamos a ir a “configuration” en el menú superior:

En su apartado “Basic” puedes seleccionar lo que quieres que crawlee Screaming Frog.

No es necesario que cojas absolutamente todo, de hecho, para agilizar el análisis de sitios web muy grandes te recomiendo que quites las imágenes, el Javascript y el CSS.

Aquí puedes seleccionar también si quieres que siga los enlaces nofollow, que analice los canonicals, subdominios y demás factores interesantes que abordaremos a lo largo del artículo.

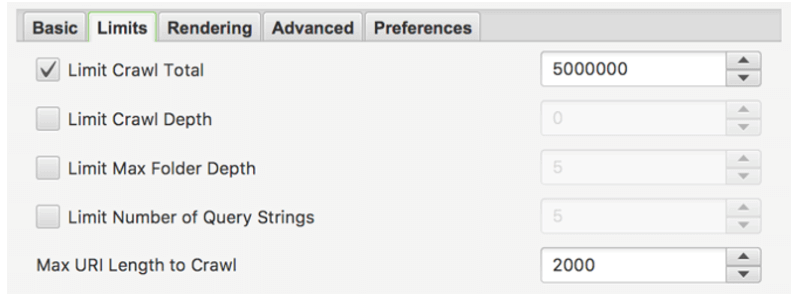

En los límites no hay mucho que ver, realmente la única que he utilizado es la de “Limit Crawl Depth”. Con ella, podrás indicar la profundidad máxima en la que buscará.

Si por ejemplo pones el número 3, la herramienta solo crawleará hasta las secciones que se encuentren a 3 clics de la home.

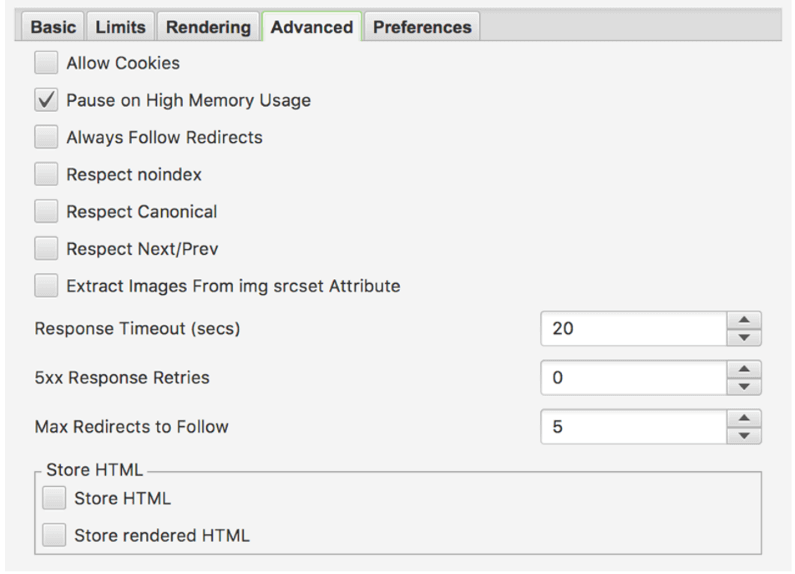

En este punto “Advanced” encontrarás opciones variadas:

- ¿A qué viene lo de las cookies? Pues si el sitio que vas a analizar necesita la aceptación de cookies, lo tendrás que marcar.

- Respect noindex, canonical y next/prev son opciones que te permitirán hacer que tu informe no incluya estos parámetros (Por ejemplo, no incluirá las páginas en noindex).

- Otras configuraciones variadas.

En definitiva, aquí puedes seleccionar las opciones a tu gusto, en base a lo que vayas necesitando en cada momento.

Por último nos quedarían “Preferences” y “Rendering”. En este caso, en la primera podemos indicar cosas como los píxeles de las metas y demás aspectos. Sólo tendrás que usarla si no te sirve lo que está por defecto.

En el caso de “Rendering”, en principio yo siempre utilizo la configuración que viene por defecto, ya que es la que mejor funciona, salvo en casos muy aislados.

Seguro que te has fijado que a la derecha tienes un pequeño desplegable con más opciones, puede parecer que está un poco apartado, pero también da datos de interés.

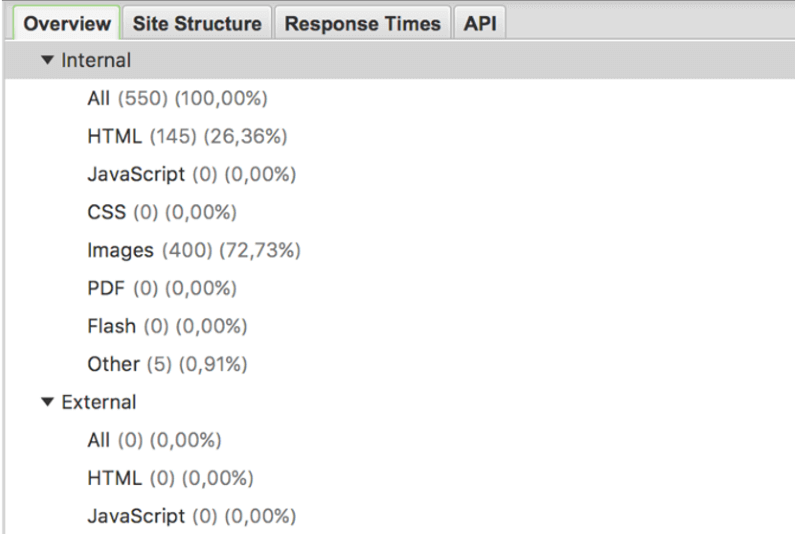

● Overview

En el apartado «overview» puedes ver un resumen general de todo lo analizado por la herramienta Screaming Frog.

Es decir, sirve para poder detectar errores de un «plumazo».

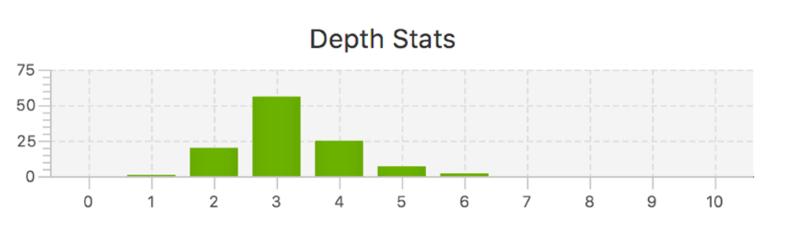

● Site structure

En el apartado de estructura del sitio verás un pequeño esquema, que te servirá para ver de forma muy visual la profundidad de tu web.

En este caso se trata de mi blog «Trabajonomada», que es una página web pequeña, pero si colocas un eCommerce un poco más grande, verás que la profundidad es mucho más grande.

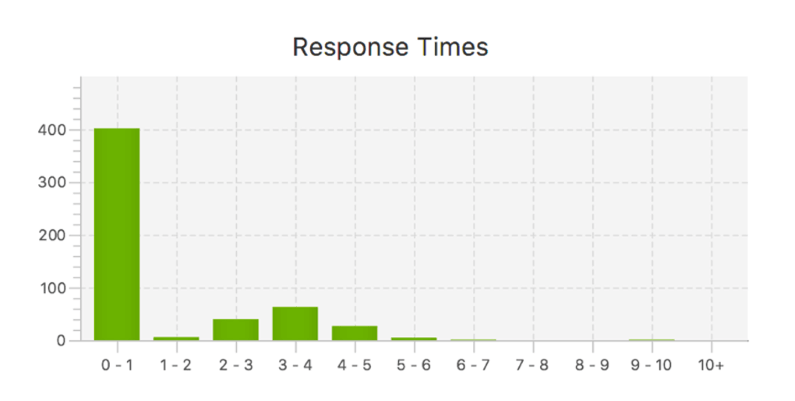

● Response time

Ya sabes lo importante que es el tiempo de carga en todo lo relacionado con el SEO e incluso con el usuario, es por eso que conviene conocer la velocidad de carga de todas tus páginas.

La verdad es que con Screaming Frog SEO Spider lo tienes muy sencillo, ya que en esta pestaña verás un gráfico muy visual, que te ayudará a estimar la carga de todo tu sitio web.

● API

En este apartado puedes ver las API’s que hayas colocado en el menú superior. Recuerda que tienes Analytics, Ahrefs, Moz y un montón más.

Personalmente, yo no las uso en todos los análisis, pero siempre está bien porque aportan mucha más información adicional.

»También te puede interesar: ¿Qué es la REST API de WordPress?

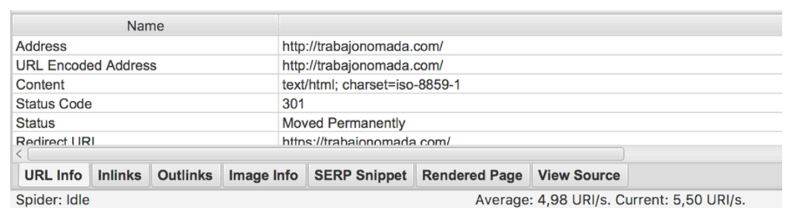

En la parte más baja de la herramienta podemos encontrar un menú como el de la siguiente captura:

A la hora de analizar una página web es muy útil, a continuación te mostramos cómo puedes usarlo:

- URL info: aquí puedes ver un montón de información como por ejemplo estatus, URI, tipo de redirección, peso, etc.

- Inlinks: verás los enlaces internos, su fuente, su destino, texto ancla y sabrás si son follow o no follow.

- Outlinks: al igual que en los inlinks verás su fuente, destino, texto ancla y follow o no follow.

- Image info: conocerás la fuente, el enlace del adjunto y el texto alternativo.

- SERP Snippet: una muestra de cómo se ve esa página en las SERP de Google.

En definitiva, este submenú es muy útil para analizar a fondo cada URL.

¿Cómo llevar a cabo un «Crawling simple» con Screaming Frog?

La herramienta ha facilitado la tarea de crawlear un sitio web al máximo.

Es súper intuitivo, pero no por eso deja de ser útil. Es por eso que en los siguientes puntos veremos los datos que se pueden conseguir desde este software.

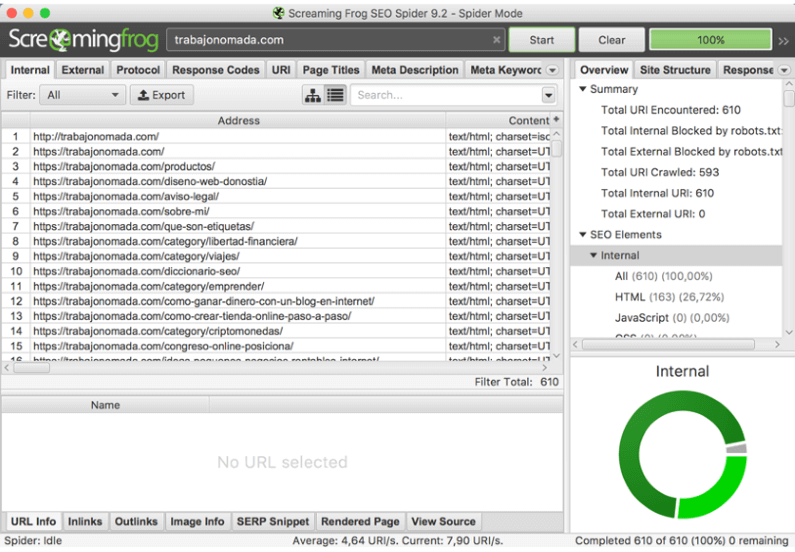

► Crawlear un sitio web completo

En este caso queremos hacer un análisis de un sitio web completo, para conseguirlo vamos a introducir la URL en la casilla que vemos en la captura.

Además, como quiero que el crawl dure lo menos posible, he quitado las opciones de CSS, Javascript y demás, que en este momento no me interesan.

Importante también decir que he quitado los links externos y que he añadido la opción de «crawl all subdomains«, para que la herramienta también los rastree.

Después de unos minutos que se me han hecho un poco largos, tengo el resultado del análisis de mi blog:

Con esto ya habrás hecho tu primer análisis con la herramienta. Como ves, Screaming Frog ya se ha encargado de crawlear todo mi sitio web, encontrando las diferentes URL’s que tiene.

► ¿Cómo excluir e incluir páginas a crawlear?

Esta funcionalidad de Screaming Frog es sin duda muy interesante, te puede ayudar a reducir el tiempo de análisis y a optimizar los datos de forma mucho más ordenada.

Veamos cómo puedes hacerlo tú mismo, a través de las expresiones regulares:

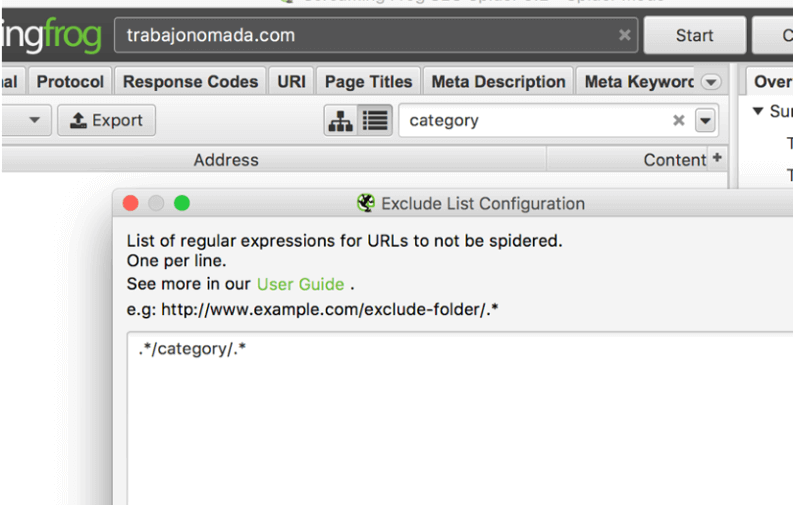

● Exclusión

Quizá la funcionalidad de «la rana» que más utilizo es la exclusión, tal y como hemos dicho funciona por expresiones regulares.

Para configurar las exclusiones, deberás ir a “Configuration > Exclude«, y se te cargará un apartado como éste:

En él tendrás que colocar tus expresiones. Aquí te dejo varios ejemplos de lo que puedes excluir (sacadas de su propia página):

- Parámetros: si por ejemplo no quieres que se incluyan parámetros como de precio, paginación y demás puedes hacerlo así: .*\?precio.*

- Categorías: también puedes eliminar el crawleo de categorías de la misma manera: https://www.ejemplo.com/.*/marca.*

Este tipo de exclusiones las puedes hacer a tu gusto siguiendo alguna guía de expresiones regulares. Aquí tienes más ejemplos.

● Inclusión

Esto es muy útil para indicarle a la plataforma qué URLs queremos analizar, en general puede venirte bien para analizar sólo un área de la web.

No obstante, tiene una pega que es lógica, y es que para encontrar las páginas con tu expresión regular, deberás empezar el crawl por una página que la enlace.

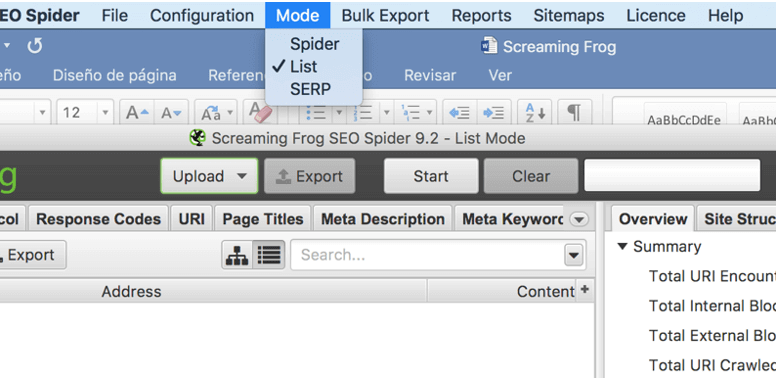

► ¿Cómo crawlear resultados concretos?

Esta problemática puede suceder, recuerda que Screaming Frog SEO Spider es un crawler, pero es posible que por ejemplo tú sólo quieras sacar los canonical, las metas o cualquier otro dato de unas páginas concretas.

En ese caso, las puedes copiar en un txt o directamente pegarlas, ya que la herramienta por sí sola hará su trabajo. Es muy sencillo, solo tienes que ir a “Mode” en el menú superior y cambiar a la opción list.

Te aparecerá algo como en la captura anterior, con un selector de Upload en el que podrás seleccionar:

- Adjuntar desde un documento.

- Pegar la lista.

- Introducirlos manualmente.

- Subirlos desde el Sitemap.

Tú eliges cuál elegir, pero ya ves que es muy sencillo de hacer, ¿verdad?

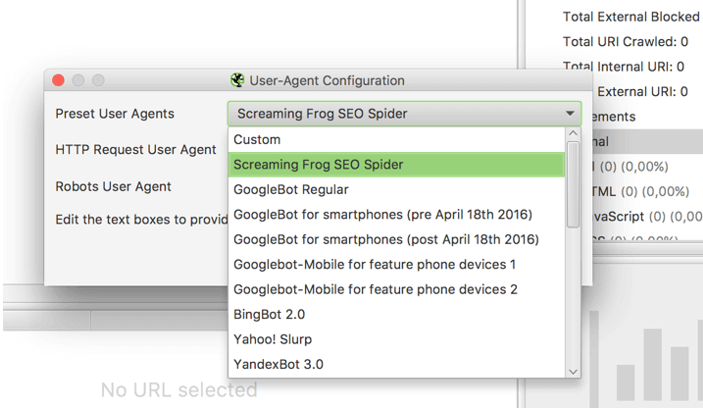

► ¿Cómo cambiar el «user-agent» o hacer el crawleo con un proxy?

Es posible que por una razón o por otra necesites cambiar de user-agent.

Principalmente esto se puede deber a que la web tenga bloqueado el crawler de Screaming Frog que viene por defecto.

En ese caso podrás seleccionar Googlebot, Googlebot mobile y otras opciones que ves en la captura; solo tendrás que dirigirte a «configuration > user-agent» y elegir lo que más te cuadre.

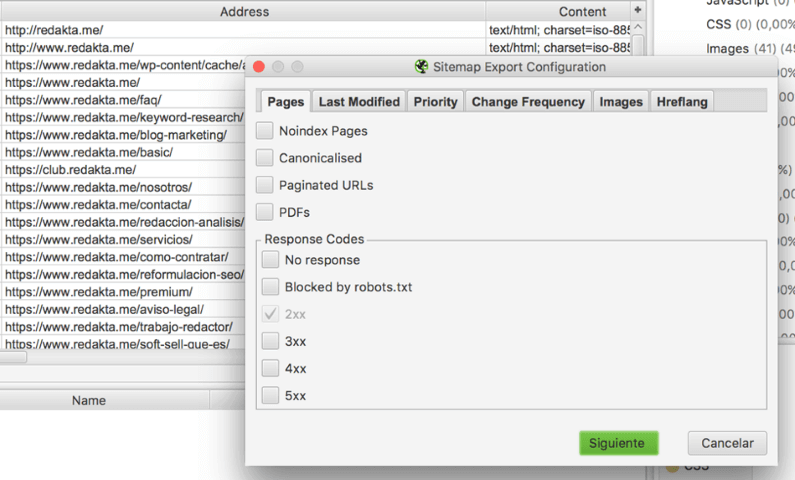

► ¿Cómo crear un sitemap.xml con Screaming Frog SEO Spider?

Los sitemap sirven para indicar a Google cuales son las páginas por las que debe pasar, es por eso que tener un mapa de sitio bien optimizado es de vital importancia.

Para crearlo tendrás que dirigirte al menú principal al apartado Sitemaps, y en él pulsar en create a sitemap:

Sigue los pasos que aparecen en las diferentes pestañas y Screaming Frog te creará un mapa de sitio listo para subir a tu web.

PD: En caso de que lo tengas ya creado y sólo quieras comprobar que funciona bien sólo debes guardarlo y subirlo en modo lista.

¿Cómo podemos aumentar la memoria de Screaming Frog en un ordenador «Mac»?

Si bien es cierto que ella no es una herramienta especialmente creada para crawlear sitios enormes o muy grandes, la verdad es que ese trabajo se le da genial.

No obstante, según la configuración de tu ordenador, puede que no estés aprovechando toda su «chicha».

Por defecto Screaming Frog utiliza 512 MB, y eso para un sitio medianamente grande es muy poco, así que como usuario Mac, lo único que tendrás que hacer será ir a «Terminal» (puedes hacerlo en buscar) y escribir la siguiente línea:

defaults write uk.co.screamingfrog.seo.spider Memory XX

En la XX tendrás que poner la memoria que quieras destinar, por ejemplo 2g (2 gigabytes) o 2048m (2 megabytes).

Screaming Frog SEO Spider también te ayuda a optimizar tus contenidos

Como has podido ver la herramienta Screaming Frog es muy necesaria en cualquier estrategia de posicionamiento Web, veamos ahora cómo podemos optimizar nuestros contenidos siguiendo sus directrices.

Nada más ver el panel principal de la herramienta, aparecen un montón de columnas, que sirven para mostrarnos los dato. A continuación, veremos todos los que tienen relación con el contenido:

► Internal

Es la pestaña principal, y congrega la mayor parte de la información que nos da la herramienta.

- Código de estado: te servirá para saber si la página es OK (200), está redireccionada (3XX), si da error (4XX)…

- Título y descripción: verás los títulos y descripciones junto con su longitud y sus pixels.

- Encabezados: ésta también te da los H1 y H2 utilizados y su longitud.

- Meta robots: verás si su meta robots es noindex, nofollow, etc.

- Canonical: podrás ver donde apunta la canonical de un simple vistazo, también en la barra lateral te indica el porcentaje de URLs sin canonical.

- Tamaño: peso de la página en bytes.

- Palabras/text ratio: número de palabras y ratio de texto.

- Crawl depth: te sirve para ver la profundidad en la que está cada página.

- Inlinks: verás el número de enlaces internos, también los únicos en la siguiente columna.

- Outlinks: verás los links salientes a otras páginas internas.

- External outlinks: en este caso puedes ver los enlaces externos, hacia otras páginas ajenas.

- Hash: es una codificación que sirve para identificar una página y distinguirla de las demás.

- Tiempo de respuesta: como su propio nombre indica, verás el tiempo que tarda en responder cada página.

Teniendo esto en cuenta, ya sabes analizar un montón de cosas en tu sitio web.

Si quieres exportar algún documento, puedes hacerlo de forma sencilla, tanto en el botón exportar de la parte superior izquierda, como en el menú.

Lo veremos más adelante en el apartado de informes.

► External

Este punto es casi igual que el anterior, pero a la inversa. En lugar de hablar sobre URL’s y enlaces internos, verás información de los externos.

Personalmente, esta función la utilizo para sacar enlaces externos que den redirección o error, no me gusta enlazar mal a dominios externos, así que por eso suelo tener esto en cuenta.

Una vez localizo los enlaces enfermos, los cambio a mano y listo, a otra tarea.

► Protocolo

Aquí podrás ver las páginas con http y https, este punto es especialmente útil si has hecho un cambio a SSL. Simple, ¿verdad?

► Response codes

Los códigos de respuesta son los famosos numeritos 3xx, 4xx y demás. Con este punto lo tienes fácil, todo lo que no sea 200 tiene algo raro, así que te toca echar un vistazo y revisar el motivo por el que está así.

A priori es normal tener varios 3xx o 4xx, simplemente analiza los resultados y busca soluciones.

¡Sin agobios!

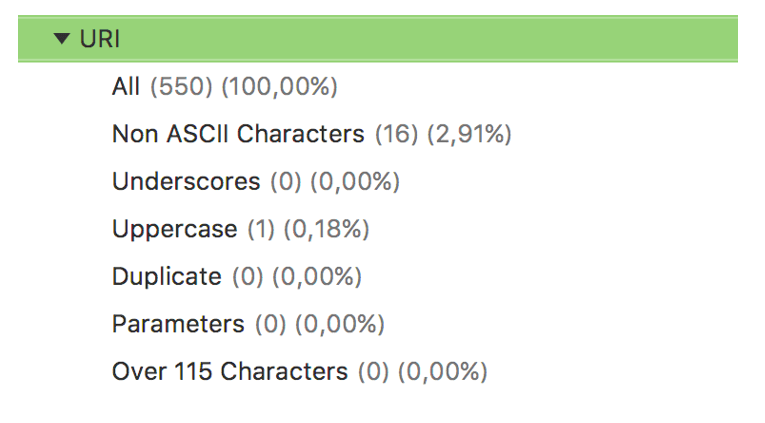

► URI

El punto URI es interesante aunque lo cierto es que si utilizas WordPress, deberías tener la mayor parte de puntos de forma correcta. En la siguiente captura puedes ver los casos que se pueden dar:

Como puedes ver, podrás comprobar si alguna uri tiene caracteres extraños, si tiene barras bajas, mayúsculas, duplicadas, URLs con parámetros y por último URLs con más de 115 caracteres.

Son detalles que conviene revisar para asegurarnos de que están bien, y gracias a Screaming Frog lo podrás hacer de un vistazo.

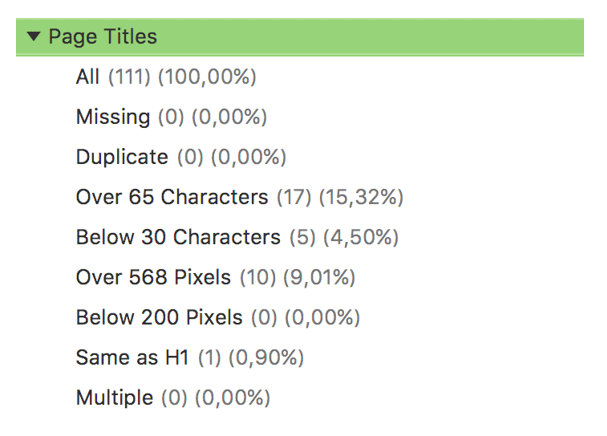

► Títulos y meta descripciones

En este punto puedes ver varias características de tus títulos y descripciones, de un plumazo podrás sacar:

Títulos y descripciones vacías, duplicadas, demasiado largas, demasiado cortas y demás. Con esto podrás sacar errores a granel y solucionarlos de forma rápida y sencilla.

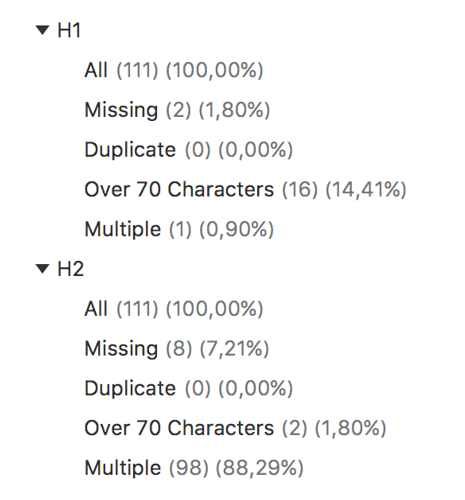

► Encabezados

También podrás sacar buenos detalles de los encabezados H1 y H2, de un plumazo sacarás la siguiente información:

Encabezados vacíos, duplicados, largos y múltiples. En el caso de los H2, este punto de múltiples no es un problema. De hecho, es positivo así que no te preocupes.

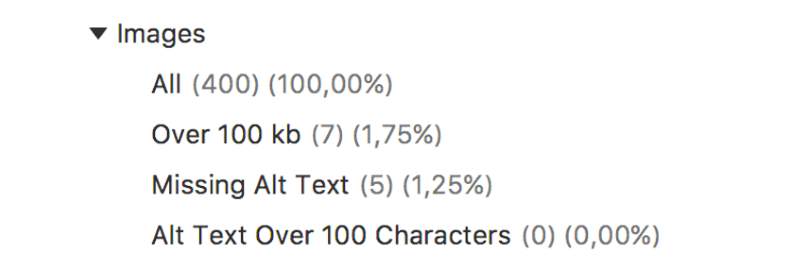

► Imágenes

Las imágenes son uno de los principales errores de la mayoría de webmasters, por un lado tenemos el peso, que si no se optimiza puede hacer que tu web sea «más lenta que el caballo del malo».

Por otro la optimización de las fotos, factor del que mucha gente pasa.

Con ella podrás ver las imágenes que pesen más de 100kb, las que no tengan texto alternativo y por último las que contengan un alt demasiado largo.

Este informe es importante, ya que como digo, las imágenes son un gran olvidado en el SEO de muchas webs.

»También te puede interesar: ¿Cómo comprimir fotos sin perder calidad?

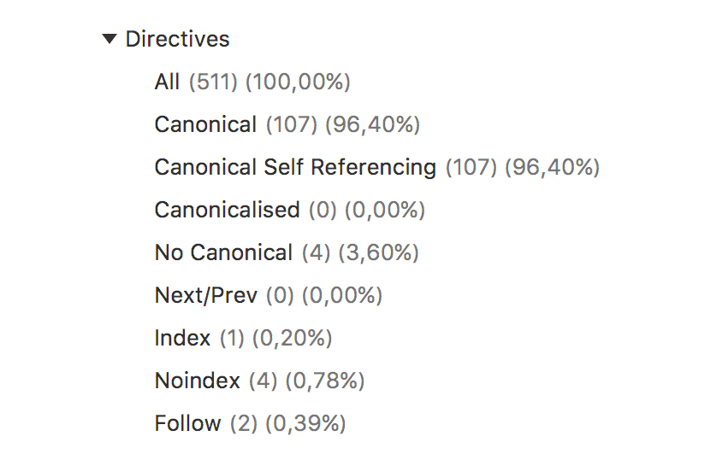

► Directivas

En este punto también puedes sacar información muy importante para optimizar tu sitio web:

Por un lado verás las canonical, algo muy importante en el SEO. Conviene que revises esto, aunque en este caso, si tienes WordPress, también puedes estar más tranquilo.

El resto de directivas son el next/prev, el noindex y el nofollow. Esta pestaña te da información relevante sobre estos puntos, que podrás utilizar para mejorar tu On page.

► Hreflang

El hreflang sirve para indicar a Google el contenido en diferentes idiomas, en este caso ella también te ayudará a ver si tu sitio tiene todo bien colocado.

► API

Si introduces las API’s de las diferentes herramientas con las que se asocia Screaming Frog, podrás sacar datos más avanzados.

Las plataformas posibles son las siguientes:

- Google Analytics.

- Search Console.

- Majestic.

- Ahrefs.

Te recomiendo que pruebes a colocarlas, al menos para hacer la prueba en una ocasión y tener datos completos.

Extracción de informes con Screaming Frog

Ver los datos en la herramienta está genial, pero si que es cierto que de cara al cliente, necesitas generar informes sencillos y más visuales, con los que poder convencerle para tomar las mejores decisiones.

Es por eso que no podía faltar un pequeño punto en el que se hable sobre la extracción de informes, en este caso, primero para los inlinks:

Links internos

En este punto te podrás descargar varios informes en bruto:

- Enlaces hacia una página.

- Enlaces desde una página.

- Anchor text de los enlaces internos.

Será tan sencillo como que te dirijas al menú superior, «bulk export» y que elijas una de las tres primeras opciones. Te descargarás el archivo Excel en formato «csv» y podrás manipularlo en el programa directamente.

Imágenes

Antes hemos dicho que las imágenes tienen una gran importancia, es por eso que también puedes exportar este tipo de informes en un clic.

- Imágenes sin alt.

- Imágenes con más de 100kb.

- Todas las imágenes.

Esto es muy útil cuando tu cliente te pide algo así como:

¿Qué puedo mejorar en el On-page de mi sitio web para que sea más rápida?

Gracias a esta plataforma, lo sacarás todo en un para de clics… y «a otra cosa mariposa».

Links externos

En Screaming Frog también hay lugar para los enlaces externos, podrás exportar un documento con todos los enlaces hacia otros dominios, para así dividirlos por código de respuesta o por lo que tú quieras.

A pesar de que este análisis lo puedes hacer directamente en la herramienta puede ser interesante exportarlo a una hoja de cálculo, sobre todo si hablamos de un sitio web grande.

Códigos de respuesta

Conocer los códigos de respuesta es muy importante en el SEO, es por eso que otro uso clave de Screaming Frog es éste. Entre los informes que puedes sacar están los siguientes:

- Bloqueado por Robots.txt

- Sin respuesta.

- 200OK.

- Redirección 3XX.

- Redirección Javascript o metarefresh.

- Error 4XX.

- Error de servidor 5XX.

Directivas

Las directivas las hemos visto anteriormente, las más relevantes para mí son las canonical, pero puedes extraer cualquiera de las que hemos visto en la captura anterior.

Reports

Otro punto del menú que tiene mucha importancia es el apartado reports, en el que puedes descargar un montón de datos adicionales.

- Resumen del crawl.

- Errores de canonicals.

- Cadenas de redirecciones.

- Errores prev/next.

- Hreflang.

- Contenido inseguro.

Como ves, puedes exportar un buen montón de cosas.

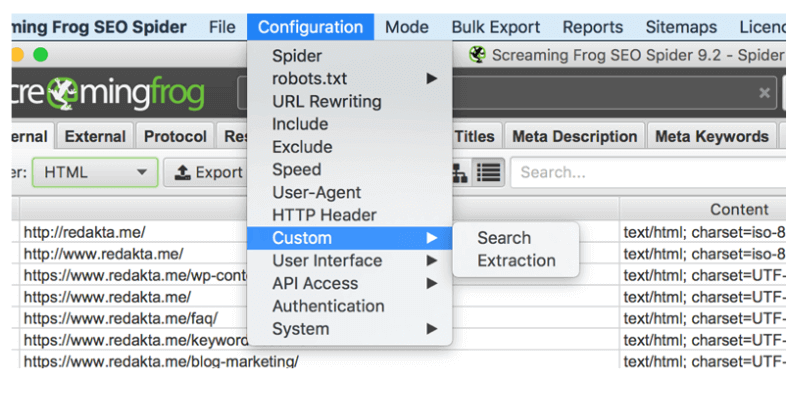

Custom Search y Custom Extraction: extrae lo que tú quieras

Ahora, veremos en detalle cómo podemos utilizar los filtros personalizados.

Sin duda se trata de dos funcionalidades muy interesantes, además al explicar en qué consiste el “Custom Search y Custom Extraction” pondré varios ejemplos que te aclararán mucho más, pero antes vamos a ver en qué consiste cada caso.

¡Hey! Casi me olvido, las puedes encontrar en el menú superior en el apartado «Configuration > Custom».

► Búsqueda a medida

Vaya traducción cutre me he marcado. ¿Eh? En fin, bromas aparte, esta función te permitirá localizar casi cualquier cosa dentro del código fuente de una página web.

► Extracción a medida

A diferencia de la búsqueda, en este caso te permitirá extraer los datos para ti. Como es obvio, para que funcione la página debe dar un código 200 ya que de otro modo no la podrá leer.

Si al igual que yo, no eres muy técnico, quizá no entiendas esto, pero te diré que los formatos que lee son estos:

- XPath incluyendo atributos.

- CSS path y opcionalmente los atributos.

- Expresiones regulares.

Sin ir más lejos, vamos a ver de forma práctica cómo podemos utilizar este tipo de búsquedas y extracciones:

● ¿Cómo saber si el código de Analytics funciona en todas las páginas?

Medir es una parte muy importante en SEO y para asegurarte de que estás midiendo todo bien conviene saber si todas las páginas cuentan con un código de Analytics o de Tag Manager.

Esto lo puedes comprobar de forma muy sencilla con la búsqueda:

Colocas el código de Analytics y «Does Not Contain», y vuelves a realizar el crawl. Ahí te aparecerán los datos de si está puesto en todas las páginas o no.

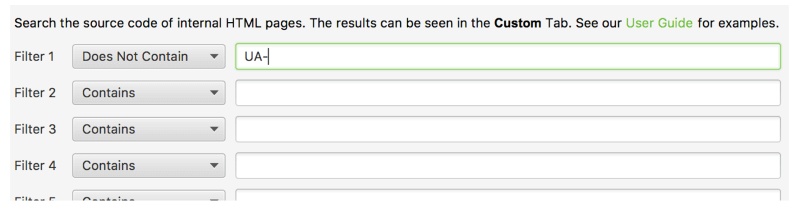

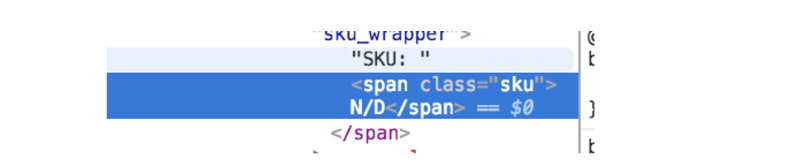

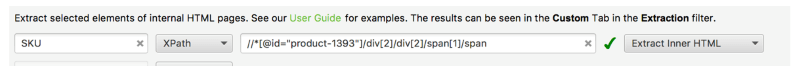

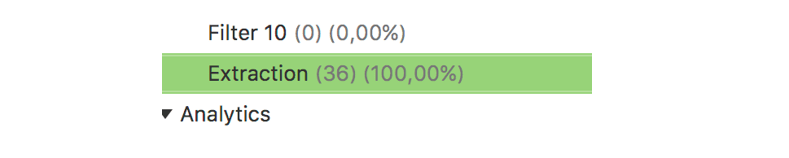

● Sacar un dato concreto (Ejem: SKU)

Si quieres sacar un dato concreto de tu blog o de tu eCommerce, como por ejemplo el SKU de los productos lo puedes hacer de forma muy sencilla.

Lo primero que debes hacer es dirigirte a una página con SKU, clic derecho y seleccionar “inspeccionar elemento”. Ahí en la consola de inspección clicas de nuevo con el derecho y vas a «copiar > copiar xpath».

Ahora que ya lo tienes vuelves a «Screaming Frog > Configuration > Custom > Extraction«, y te saldrá algo así:

Copias los datos de xpath en la segunda columna y seleccionas xpath en las opciones. Listo, vuelves a pasar el crawl y ya lo tienes listo:

Te aparecerán todos los datos en la consola principal. Fácil, ¿verdad?

En definitiva, ya hemos visto dos opciones de las custom extraction y search de Screaming Frog, seguro que se te ocurren cosas que puedes hacer con estas funciones.

¡A darle al coco!

¿Cómo utilizar los filtros personalizados “Custom Search y Custom Extraction”?

Últimas dudas y conclusiones sobre la herramienta

Espero que este artículo te haya ayudado a comprender mejor cómo puedes usar Screaming Frog para mejorar el SEO de todo tu sitio web.

Viendo ahora este mega manual, en mi cabeza ha quedado todo más claro y espero que en la tuya también, porque la verdad es que me he dejado todo aquí.

No obstante es posible que te haya surgido alguna duda, así que estaré encantado de responderte a través de los comentarios ¡Y si te ha gustado también te agradeceré tu comentario!

En fin, antes de despedirme recordarte que ésta es una excelente herramienta que te puede ayudar a hacer un montón de cosas.

Ahora depende de ti utilizarla y darle nuevas funcionalidades en base a lo tratado hoy.

Imágenes (Rocket) propiedad de Freepik.

¿Qué funcionalidades de Screaming Frog SEO Spider te son más útiles para tu proyecto?

Muchas gracias por haberte tragado todo el tocho de post, que en ocasiones ha podido ser bastante denso.

Muchas Gracias Frank ahí te comento como me va, estoy con la versión free para educación. un abrazo

Recomiendo probar SiteAnalyzer, un programa gratuito para la auditoría y el análisis técnico del sitio. Al mismo tiempo, el conjunto de funciones no es prácticamente inferior a las contrapartes pagadas.

Hola SiteAnalyzer, gracia spor tu recomendación, saludos

Una de las guías más completa por no decir la más, de Screaming Frog. La calidad de este contenido es inmejorable como es tambien esta herramienta. En mi opinion esta herramienta deberia ir en el bolsilo de cada SEO.

Hola Carlos, cierto, la verdad es que Screaming Frog es una herramienta imprescindible si haces trabajos de SEO para ti o para clientes 😉 Para llevarla siempre encima. ¡Saludos!

Sin duda es una herramienta genial y gratuita para sitios web grandes! Muy buena guía! Aunque ahora con las novedades de ahrefs … pero esta es gratis 😀

Hola amigo/a, lo cierto es que, Screaming Frog, en su versión «Free» es muy completa para todo lo relacionado con el análisis SEO. Saludos

Esto es lo que se llama una Mega Guía para analizar y optimizar tu SEO On-Page a día de hoy es muy vital el analisis del SEO On-Page en los blog wordpress si queremos escalar. Muy buena explicación sobre como utilizar Screaming Frog SEO Spider, no la conocía esta, sigo diciendo que se aprende todo los dia

Hola Josías, gracias por tu opinión. La verdad es que, efectivamente, nuestro amigo Fran Murillo ha hecho un gran trabajo con esta mega guía de Screaming Frog 😉 Saludos